Optimizado para tu tranquilidad

El Hosting de las cosas que te importan

Potencia tu Tienda Online Potencia tu Tienda Online

Servidores Cloud optimizados para ecommerce con máximo rendimiento, seguridad SSL y escalabilidad instantánea. Ideal para WooCommerce y PrestaShop

Hosting

Planes únicos al mejor precio del mercado para no dudar en ningún momento.

Cloud

Crecimiento progresivo a una velocidad de vértigo gracias al almacenamiento NVMe distribuido.

Dedicados

Toda la potencia que necesitas con recursos dedicados.

Beeroot 360

Infraestructura profesional y un soporte de calidad, olvídate de las caídas y la lentitud.

Tenemos una solución para ti

Contamos con planes de alojamiento web adaptados a cada fase de tu proyecto, poderosos entornos cloud y opciones exclusivas para distribuidores. Tenemos lo que necesitas.

Dominios

Reserva tu dominio y consolidate en internet.

1,79 €

desde

año

- Redirección web

- Panel de control

- Gestión NameServers

- Tabla DNS

- Parking

- Redirección de correo

Hosting

Aloja tu web en nuestros potentes planes de hosting.

1,49 €

desde

mes

- Hosting Web

- Hosting Wordpress

- Hosting WooCommerce

- Hosting Prestashop

Cloud

Un servidor que escala con el crecimiento de tu negocio.

9,95 €

desde

mes

- Servidor escalable

- Recursos dedicados

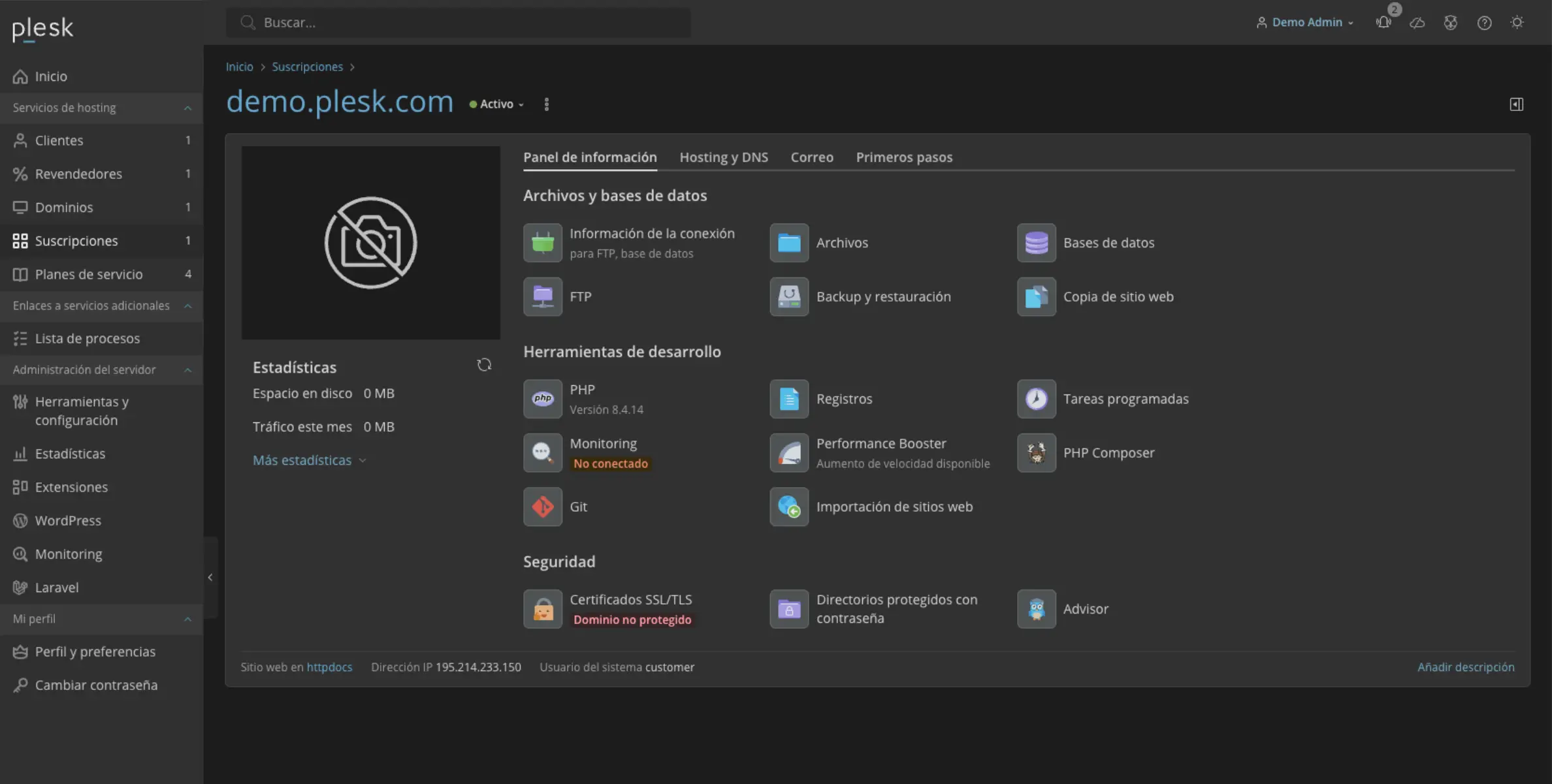

- Panel de control Plesk

- Monitorizado

- Acceso administrador

Hosting Pro

Crea tus propios clientes y gestiona sus webs.

8,99 €

desde

mes

- Acceso independiente a clientes

- Versiones de PHP por cliente

- Auto-instalador de aplicaciones

- Crea tus propios planes de hosting

Beneficios de ser cliente de sys4net

Descubre que nos hace únicos y nos diferencia de otras empresas

- SOPORTE TÉCNICO 24x7x365

Puedes contactar con nosotros los 365 días del año. Ya sea por correo, chat, ticket o teléfono, estaremos aquí para resolver todas tus cuestiones.

Contactanos- CENTRO DE DATOS PROPIO

Tenemos nuestra propia infraestructura en nuestro datacenter de Murcia, no dependemos de un centro de datos externo que pueda afectar a la disponibilidad de tu web.

Ver más- GUÍAS PRÁCTICAS

Nuestros expertos han creado sencillas guías para nuestros clientes, en las que exponen como realizar tareas cotidianas en tu alojamiento o servidor.

Ver guías

¿Necesitas ayuda con la gestión de tu ecommerce?

Con Beeroot 360 contarás con la administración total de tu servidor y aplicativo

De la tecnología nos encargamos nosotros

Conoce Beeroot 360Servicios que vas a disfrutar con Beeroot:

Infraestructura para tu negocio online y soporte 360

- Monitorización 24/7

Nos encargamos de instalar agentes de monitorización en tu web para tener todo bajo control y anticiparnos a los problemas.

- Atención proactiva y reactiva

No solo respondemos a tus peticiones sino que también actuamos proactivamente si, mediante monitorización, detectamos cualquier peligro.

- Soporte de correo electrónico

Revisión de logs, análisis de correos devueltos y resolución de incidencias para asegurar el correcto funcionamiento de tu servicio de email.

- Revisión de logs generales

Analizamos registros y errores para detectar incidencias y optimizar el funcionamiento de tu sistema.

- Peticiones de cambio

Gestionamos solicitudes de modificación, actualizamos versiones de PHP y MySQL e instalamos elementos en el panel de control para mantener tu entorno actualizado y funcional.

- Actualización del S.O. y Panel

Realizamos actualizaciones semalaes para garantizar seguridad, estabilidad y rendimiento óptimo.

- Filtro de correos salientes

Colocamos un filtro de hasta 10.000 mensajes al mes, asegurando que tus correos no terminen en listas negras y manteniendo la reputación de tu dominio.

- Optimización avanzada del servidor

Mejoramos el rendimiento, estabilidad y eficiencia mediante ajustes técnicos especializados a medida.

- Atención de incidencias en aplicativos

Revisamos logs, accedemos al backend, verificamos configuraciones, comprobamos integraciones con otros sistemas, para ayudar al equipo de desarrollo a localizar y corregir fallos.

- Instalación de componentes avanzados

Configuramos e instalamos elementos no estándar como Redis, Docker, Elasticsearch, asegurando su correcta integración en el panel de control y el funcionamiento óptimo en el servidor.

- Actualizaciones críticas inmediatas

Aplicamos sin demora parches y actualizaciones esenciales para corregir vulnerabilidades y garantizar la seguridad y estabilidad del sistema.

- Soporte de máxima prioridad

Nuestro equipo especializado de N2 atiende incidencias urgentes con respuesta preferente, las 24 horas del día, los 365 días del año.

El Poder de Plesk

Control total en tus manos.

Navega con facilidad y personaliza tu experiencia con nuestro innovador panel de control Plesk. Diseñado para ofrecerte un control total y una navegación intuitiva. ¡Explora Plesk hoy mismo!

Nuestro clientes opinan

Responsable de servicios IT pccomponentes.com

PCComponentes como empresa líder de tecnología líder en comercio electrónico en España, […] Llevamos muchos años confiando en sys4net como nuestro Centro de Datos de confianza.

Juan Moral, Responsable de sistemas e infraestructura en Aquaservice

En Aquaservice demandamos un alto nivel de infraestructura […]. En sys4net hemos encontrado ese socio tecnológico que además de alojar nuestras webs nos brindan los servicios cloud necesarios y asesorando a nuestro departamento de IT mediante un soporte técnico 24/7.

Pedro Antonio Mondéjar, Director de Informática en Vidal Golosinas

En Vidal Golosinas contamos con el servicio de Hosting de sys4net desde hace años. En él hemos encontrado un gran equipo de profesionales comprometidos, con un eficaz soporte técnico directo y cercano. […]